제대로 사용하자! GPT 파인 튜닝 가이드

GPT 모델 파인튜닝 완벽 가이드

초보자도 쉽게 따라하는 GPT 모델 맞춤형 학습 방법

🧠 GPT의 학습 원리: 왜 파인튜닝이 필요할까요?

안녕하세요, 여러분! AI 챗봇을 만들어보고 싶은데 "내 회사 데이터에 맞게" 설정하고 싶으셨나요? 아니면 의료 분야나 법률 분야같이 특정 전문 영역에서 더 정확한 답변을 주는 AI를 원하셨나요? 바로 이럴 때 필요한 게 파인튜닝(Fine-Tuning)입니다.

1. GPT는 어떻게 학습할까요?

GPT 모델은 크게 두 단계로 학습합니다.

① 사전 훈련(Pre-training): "세상 공부하기"

GPT-4같은 모델들이 처음 만들어질 때 인터넷의 방대한 텍스트, 책, 뉴스, 논문 등을 읽고 언어의 패턴을 배웁니다. 마치 아이가 다양한 경험을 통해 세상을 배우는 것처럼요.

예시: ChatGPT는 수십억 개의 웹페이지, 책, 위키피디아 문서 등을 학습했어요. 그래서 "사과는 어떤 과일인가요?"라고 물으면 일반적인 지식을 바탕으로 답변할 수 있습니다.

② 파인튜닝(Fine-Tuning): "전문가 되기"

사전 훈련된 모델을 특정 분야나 목적에 맞게 추가로 학습시키는 과정입니다. 마치 의대를 졸업한 의사가 특정 분야(예: 심장학)에서 전문의가 되기 위해 추가 교육을 받는 것과 비슷합니다.

사례: 의료 상담 AI를 만드는 회사 A는 GPT 모델을 수만 건의 의료 상담 데이터로 파인튜닝했더니, 일반 GPT보다 의학 용어 이해도가 23% 향상되고, 의료 질문에 대한 정확도가 35% 증가했습니다.

🔄 파인튜닝 방식 - 꼭 고사양 컴퓨터가 필요할까요?

"파인튜닝하려면 비싼 컴퓨터가 필요하다"는 오해가 있는데요, 사실 방법에 따라 다릅니다! 아래 두 가지 방식을 확인해보세요.

1️⃣ 직접 모델 훈련하기

- 필요 장비: 고성능 GPU가 장착된 컴퓨터

- 비용: 높음 (GPU 구매 또는 클라우드 서버 임대)

- 자유도: 매우 높음 (모든 설정 직접 조정 가능)

- 난이도: 높음 (코딩 및 ML 지식 필요)

- 적합한 경우: 매우 특수한 도메인, 보안이 중요한 경우

2️⃣ 클라우드 서비스 활용하기

- 필요 장비: 일반 노트북/PC로 충분

- 비용: 사용량에 따른 API 비용

- 자유도: 중간 (제공 옵션 내에서 선택)

- 난이도: 낮음 (웹 인터페이스 사용)

- 적합한 경우: 일반적인 비즈니스 사용, 빠른 개발

초보자를 위한 팁! 처음 파인튜닝에 도전한다면 OpenAI나 HuggingFace 같은 클라우드 서비스를 이용하는 것이 좋아요. 코딩보다 데이터 준비에 집중할 수 있고, API 키만 있으면 쉽게 시작할 수 있습니다.

방식 1: 직접 모델을 돌리는 경우

오픈소스 LLM(예: LLaMA, Falcon, Mistral 등)을 직접 다운로드하여 자신의 컴퓨터나 서버에서 학습시키는 방식입니다.

장단점

- 장점: 모든 과정을 통제할 수 있고, 원하는 대로 모델 구조까지 변경 가능

- 단점: 고성능 GPU(NVIDIA RTX 3090 이상)가 필요하며, 기술적 지식이 많이 요구됨

# 직접 훈련 예시 (PyTorch + Transformers 사용)

from transformers import AutoModelForCausalLM, AutoTokenizer, Trainer, TrainingArguments

import torch

# 모델과 토크나이저 로드

model_name = "meta-llama/Llama-2-7b-hf" # 오픈소스 모델 예시

model = AutoModelForCausalLM.from_pretrained(model_name)

tokenizer = AutoTokenizer.from_pretrained(model_name)

# 훈련 설정

training_args = TrainingArguments(

output_dir="./results",

num_train_epochs=3,

per_device_train_batch_size=4, # GPU 메모리에 따라 조정

save_steps=1000,

logging_steps=100,

)

# 트레이너 설정 및 실행

trainer = Trainer(

model=model,

args=training_args,

train_dataset=your_dataset, # 준비한 데이터셋

)

trainer.train()

방식 2: 클라우드/웹 서비스 이용하기

OpenAI API, Azure OpenAI 서비스, HuggingFace 등에서 제공하는 파인튜닝 API를 이용하는 방식입니다.

장단점

- 장점: 별도의 GPU 없이도 노트북으로 가능, 웹 인터페이스로 쉽게 사용 가능

- 단점: API 비용 발생, 데이터가 외부 서버로 전송됨, 일부 설정만 제한적으로 조정 가능

사례: 스타트업 B는 고객 지원 챗봇을 만들기 위해 5천 개의 고객 문의-답변 데이터를 준비하고 OpenAI API로 파인튜닝했습니다. 일반 노트북으로 데이터 업로드만 하고, 실제 학습은 OpenAI 서버에서 진행되었습니다. 총 비용은 $150 정도였고, 3시간 만에 훈련이 완료되었습니다.

# OpenAI API를 이용한 파인튜닝 예시

import openai

import os

openai.api_key = os.getenv("OPENAI_API_KEY")

# 파일 업로드 - 일반 노트북에서도 가능

upload_response = openai.File.create(

file=open("training_data.jsonl", "rb"),

purpose="fine-tune"

)

file_id = upload_response.id

# 파인튜닝 작업 생성 - 실제 훈련은 OpenAI 서버에서 진행

fine_tune_response = openai.FineTuning.create(

training_file=file_id,

model="gpt-3.5-turbo",

hyperparameters={

"n_epochs": 3

}

)

참고: 클라우드 서비스를 이용할 때는 민감한 개인정보나 기밀 데이터가 포함되어 있지 않은지 확인하세요. 필요하다면 데이터를 익명화하거나 마스킹 처리한 후 업로드하는 것이 좋습니다.

✅ 파인튜닝 준비물: 무엇이 필요할까요?

1. 양질의 데이터셋

파인튜닝의 성패는 데이터에 달려있다고 해도 과언이 아닙니다!

# 고객 상담 AI를 위한 데이터 예시 (JSON 형식)

{

"question": "환불은 어떻게 신청하나요?",

"answer": "환불은 구매일로부터 7일 이내에 웹사이트 마이페이지 > 주문내역에서 '환불 신청' 버튼을 클릭하여 신청하실 수 있습니다."

}

데이터 수집 시 주의사항

- 양보다 질: 1만 개의 부실한 데이터보다 1천 개의 고품질 데이터가 더 효과적입니다.

- 다양성 확보: 하나의 패턴만 반복되는 데이터는 편향된 모델을 만들어냅니다.

- 실제 사용 사례 반영: 실제 사용자들이 물어볼 만한 질문들을 포함해야 합니다.

주의! 실제 사례: B사는 마케팅부서에서 작성한 '이상적인' 질문-답변 쌍으로만 챗봇을 학습시켰더니, 실제 고객들의 질문 패턴과 맞지 않아 첫 달에 70%의 질문에 제대로 답변하지 못했습니다.

2. 컴퓨팅 자원 (직접 훈련할 경우)

직접 모델을 훈련시키려면 아래와 같은 자원이 필요합니다:

- GPU: 최소 NVIDIA T4 이상 (NVIDIA A100이나 A10이 이상적)

- 메모리: 모델 크기에 따라 다르지만, GPT-3 수준 모델은 최소 16GB GPU 메모리

- 저장 공간: 데이터셋과 모델 가중치를 저장할 충분한 공간 (수십~수백 GB)

비용 절약 팁: 클라우드 GPU 서버를 이용할 경우 AWS의 스팟 인스턴스나 Google Cloud의 선점형 VM을 활용하면 최대 90%까지 비용을 절감할 수 있습니다. 또한 작은 모델로 개념 증명(PoC)을 먼저 한 후 필요시 큰 모델로 확장하는 전략이 효과적입니다.

🔄 파인튜닝 과정: 실전 가이드

1. 데이터 전처리

"쓰레기를 넣으면 쓰레기가 나온다(Garbage In, Garbage Out)"는 말이 있죠. 데이터 전처리는 모델 학습의 성패를 좌우합니다!

Step 1: 데이터 정제

# Python으로 데이터 정제하기

import pandas as pd

import re

def clean_text(text):

# HTML 태그 제거

text = re.sub(r'<.*?>', '', text)

# 중복 공백 제거

text = re.sub(r'\s+', ' ', text)

# 앞뒤 공백 제거

return text.strip()

# CSV 파일 로드

df = pd.read_csv('raw_customer_inquiries.csv')

df['question'] = df['question'].apply(clean_text)

df['answer'] = df['answer'].apply(clean_text)

Step 2: 데이터 형식 맞추기

OpenAI나 Hugging Face 등 대부분의 파인튜닝 API는 특정 형식을 요구합니다.

# OpenAI 파인튜닝용 JSONL 형식으로 변환

import json

with open('training_data.jsonl', 'w', encoding='utf-8') as f:

for _, row in df.iterrows():

json_obj = {

"messages": [

{"role": "system", "content": "당신은 친절한 고객 상담 AI입니다."},

{"role": "user", "content": row['question']},

{"role": "assistant", "content": row['answer']}

]

}

f.write(json.dumps(json_obj, ensure_ascii=False) + '\n')

2. 실제 학습 과정

Step 1: 하이퍼파라미터 설정

하이퍼파라미터는 모델 학습의 '레시피'와 같습니다. 적절히 설정해야 맛있는(?) 모델이 탄생합니다.

| 파라미터 | 권장 값 | 설명 |

|---|---|---|

| 학습률(learning rate) | 1e-5 ~ 5e-5 | 작을수록 안정적이지만 학습이 느림 |

| 배치 크기(batch size) | 4 ~ 32 | GPU 메모리에 따라 조정 |

| 에폭(epochs) | 2 ~ 5 | 데이터셋 크기에 따라 조정 |

사례: C사는 에폭을 20으로 설정했더니 과적합(Overfitting)이 발생해 학습 데이터에는 99% 정확도를 보였지만, 실제 사용자 질문에는 60%의 정확도만 보였습니다. 에폭을 3으로 줄이고 더 다양한 데이터를 추가한 후, 실제 성능이 85%로 향상되었습니다.

Step 2: OpenAI API로 파인튜닝 실행하기 (클라우드 방식)

# OpenAI API를 이용한 파인튜닝 예시

import openai

import os

openai.api_key = os.getenv("OPENAI_API_KEY")

# 파일 업로드

upload_response = openai.File.create(

file=open("training_data.jsonl", "rb"),

purpose="fine-tune"

)

file_id = upload_response.id

# 파인튜닝 작업 생성

fine_tune_response = openai.FineTuning.create(

training_file=file_id,

model="gpt-3.5-turbo", # 기본 모델 선택

hyperparameters={

"n_epochs": 3,

"learning_rate_multiplier": 2e-5

}

)

job_id = fine_tune_response.id

Step 3: 모델 성능 평가

모델 학습이 끝났다고 바로 배포하면 안 됩니다! 반드시 성능 평가를 통해 품질을 확인해야 합니다.

# 테스트 데이터로 모델 평가

import pandas as pd

from sklearn.metrics import accuracy_score, precision_recall_fscore_support

test_df = pd.read_csv('test_questions.csv')

predictions = []

for question in test_df['question']:

response = openai.ChatCompletion.create(

model="ft:gpt-3.5-turbo:my-company::7qHs9hIL", # 파인튜닝된 모델 ID

messages=[

{"role": "system", "content": "당신은 친절한 고객 상담 AI입니다."},

{"role": "user", "content": question}

]

)

predictions.append(response.choices[0].message['content'])

# 인간 평가자들의 점수와 비교

accuracy = test_df.apply(lambda row: human_evaluator_score(row['expected'], predictions[row.name]), axis=1)

print(f"평균 정확도: {accuracy.mean():.2f}")

3. 실전 배포 및 관리

파인튜닝된 모델을 실제 서비스에 적용하고 지속적으로 개선하는 방법을 알아봅시다.

① API 통합 예시

# Flask로 간단한 API 서버 만들기

from flask import Flask, request, jsonify

import openai

app = Flask(__name__)

FINE_TUNED_MODEL = "ft:gpt-3.5-turbo:my-company::7qHs9hIL"

@app.route('/api/chat', methods=['POST'])

def chat_endpoint():

data = request.json

user_message = data.get('message', '')

# 파인튜닝된 모델로 응답 생성

response = openai.ChatCompletion.create(

model=FINE_TUNED_MODEL,

messages=[

{"role": "system", "content": "당신은 친절한 고객 상담 AI입니다."},

{"role": "user", "content": user_message}

]

)

return jsonify({

"response": response.choices[0].message['content']

})

if __name__ == '__main__':

app.run(debug=True)

② 피드백 루프 구축

실제 사용자 피드백을 수집하고 모델을 지속적으로 개선하는 것이 중요합니다.

사례: D사는 매주 사용자 피드백 중 AI가 제대로 답변하지 못한 상위 20개 질문을 추출해 데이터셋에 추가하고 매월 재학습을 진행했습니다. 6개월 후 사용자 만족도가 68%에서 92%로 상승했습니다.

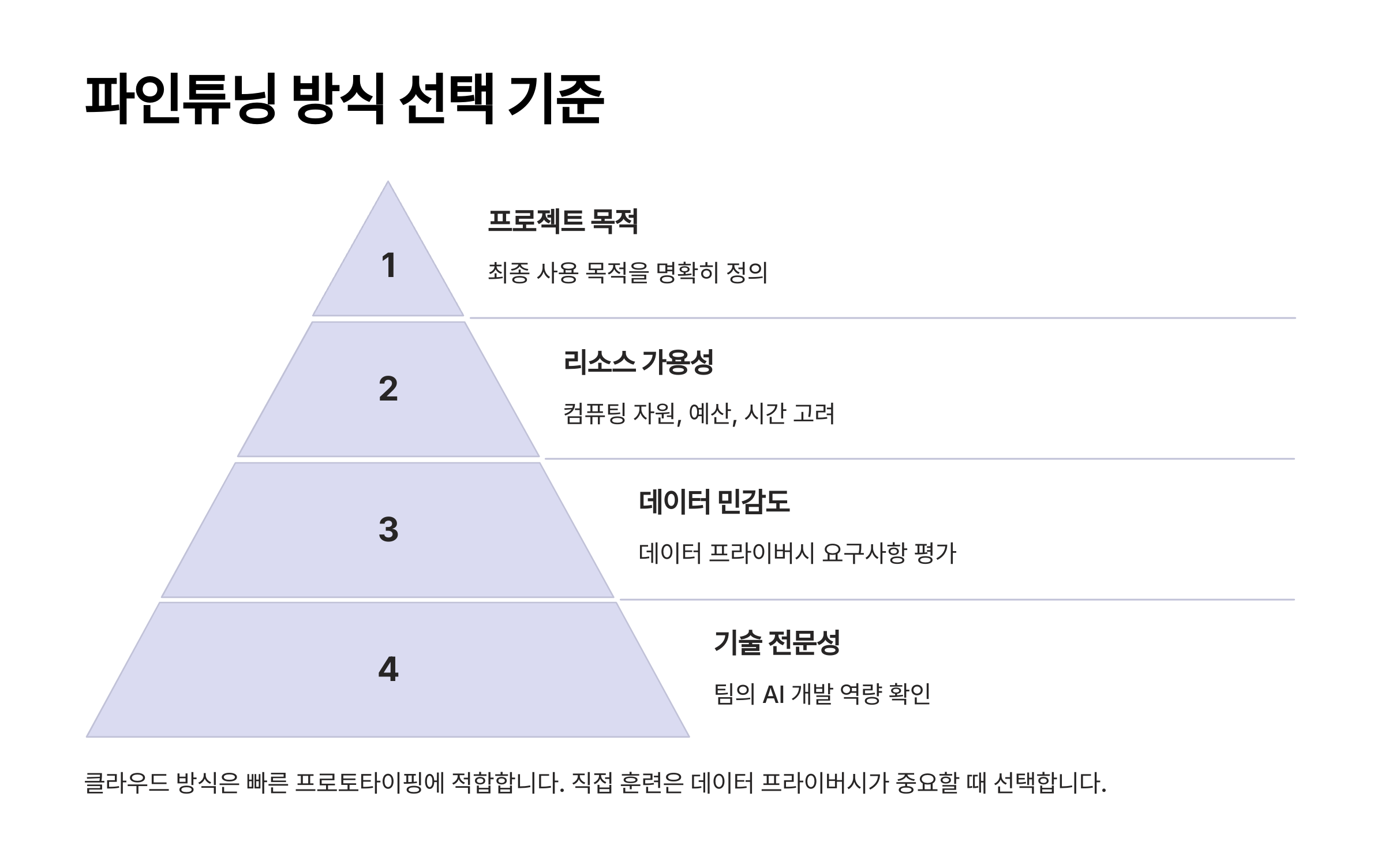

🚀 클라우드 vs 직접 훈련 - 어떤 것을 선택해야 할까요?

파인튜닝 방법을 선택할 때 고려해야 할 사항들을 알아봅시다.

클라우드 서비스가 좋은 경우

- 개발 리소스가 제한적일 때: 전담 ML 엔지니어나 고급 하드웨어가 없는 경우

- 빠른 프로토타이핑이 필요할 때: 개념 증명(PoC)이나 빠른 MVP 개발 시

- 비용 효율성을 고려할 때: 초기 투자비용 없이 사용량 기반 과금 선호 시

- 유지보수를 최소화하고 싶을 때: 인프라 관리에 드는 시간과 노력을 줄이고 싶을 때

비용 예시: OpenAI의 GPT-3.5 Turbo 파인튜닝은 학습 시 1K 토큰당 약 $0.008, 사용 시 1K 토큰당 약 $0.012의 비용이 발생합니다. 5천 개의 질문-답변 쌍(약 500K 토큰)으로 파인튜닝하면 약 $4의 학습 비용이 듭니다.

직접 훈련이 좋은 경우

- 데이터 프라이버시가 중요할 때: 민감한 데이터를 외부 서버로 보내고 싶지 않을 때

- 높은 커스터마이징이 필요할 때: 모델 아키텍처나 학습 방식을 세밀하게 조정하고 싶을 때

- 대규모 데이터셋으로 학습할 때: 장기적으로 볼 때 자체 인프라가 비용 효율적일 수 있음

- 특수한 도메인 적응이 필요할 때: 매우 전문적인 분야에 특화된 모델을 만들 때

현실적인 조언: 처음 시작할 때는 클라우드 서비스로 빠르게 시작하고, 필요와 경험이 쌓이면 점진적으로 직접 훈련 방식으로 전환하는 것이 현명합니다. 학습 곡선이 가파르기 때문에 단계적 접근이 중요해요!

🚀 파인튜닝 성공 사례 및 팁

실제 성공 사례

- 법률 문서 검토 AI: 한 법무법인은 계약서 검토를 위해 파인튜닝된 GPT 모델을 도입해 검토 시간을 70% 단축했습니다.

- 제품 추천 챗봇: 온라인 쇼핑몰은 상품 설명과 리뷰 데이터로 파인튜닝된 모델을 통해 맞춤형 상품 추천 시스템을 구축해 전환율이 23% 상승했습니다.

- 내부 지식 검색 AI: 대기업 A사는 10년치 내부 문서와 지식으로 파인튜닝한 AI를 도입해 신입사원 온보딩 시간을 45% 단축했습니다.

파인튜닝 팁 & 트릭

- 작은 것부터 시작하기: 처음부터 완벽한 모델을 만들려 하지 마세요. MVP(Minimum Viable Product)로 시작해 점진적으로 발전시키는 것이 효과적입니다.

- 데이터 합성 활용: 실제 데이터가 부족하다면, 기존 GPT를 활용해 다양한 질문-답변 쌍을 생성할 수 있습니다.

- 시스템 프롬프트 최적화: 파인튜닝과 함께 효과적인 시스템 프롬프트를 설정하면 성능을 더욱 끌어올릴 수 있습니다.

주의사항: 파인튜닝은 만능이 아닙니다! 기본 모델이 가진 한계(예: 수학적 연산 능력)를 완전히 극복하기는 어렵습니다. 또한 편향된 데이터로 학습하면 편향된 결과가 나옵니다. 항상 윤리적 측면을 고려하세요.

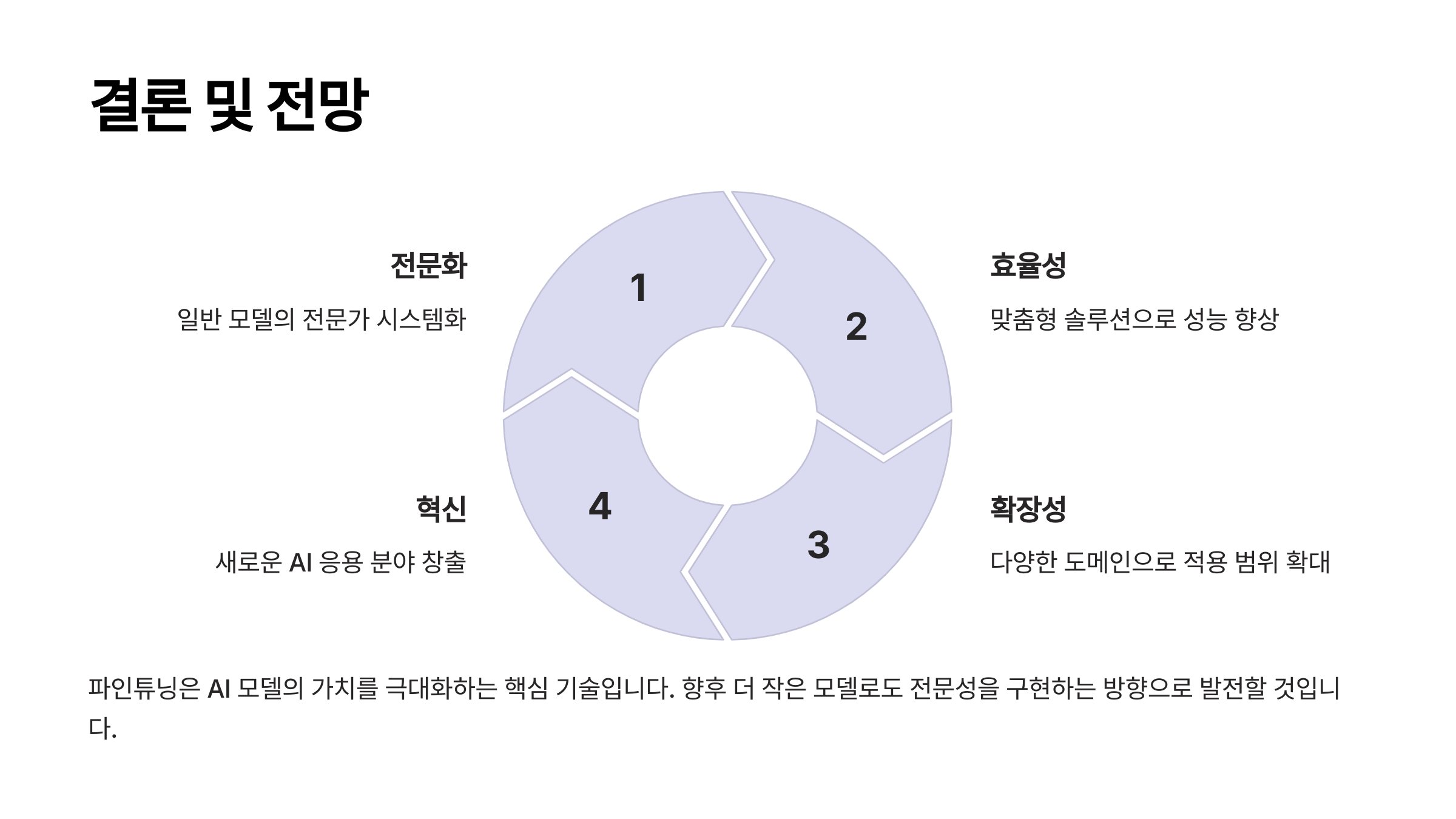

📊 결론: 파인튜닝의 미래

GPT 모델의 파인튜닝은 인공지능을 "범용 도구"에서 "특화된 전문가"로 변모시키는 강력한 기술입니다. 특히 특정 도메인이나 회사 내부 지식에 특화된 AI 구축에 매우 효과적입니다.

미래에는 더 적은 데이터로도 효과적으로 파인튜닝할 수 있는 기술(Few-shot Learning)과 파인튜닝된 모델 간의 지식 공유(Knowledge Distillation) 같은 발전이 예상됩니다.

중요한 것은 기술적인 측면뿐만 아니라 명확한 목표 설정과 양질의 데이터 확보, 그리고 지속적인 개선 사이클을 구축하는 것입니다.

GPT 파인튜닝은 단순한 '기술 도입'이 아닌, AI와 함께 성장하는 여정입니다. 작은 시작으로 큰 변화를 만들어보세요!